人工智能換臉——Deepfake

燭光網絡 126期 (p.10)

2018年,網絡開始盛行Deepfake(深度偽造,簡稱深偽)技術,這個合併詞由深度學習(deep learning)和冒充(fake)組成,它是指透過人工智能技術製造的人體圖像合成技術,將圖像及影片重疊至目標圖片或影片上。起初不少人認為這種機器深度學習技術應該只存在於人工智能研究的範疇上,但於2017年,一位名為「deepfakes」的網民將以色列女星姬嘉鐸(Gal Gadot)的樣貌換到色情片的女主角身上,[1] 並發佈在社交平台Reddit的論壇上,引起了一陣哄動,更令部份人效法這種惡意行為。

時至2024年,Deepfake已成為了網騙的一種手法,騙徒運用這門技術生成虛假的影像和聲音冒充重要人物,透過「他們」發出指示來騙取金錢;另外在美國、南韓的校園裡亦發生過運用Deepfake技術來欺凌同學的事件。[2]

免費程式可轉換圖像

Deepfake並不是甚麼高深的技術,以往網上也有相關的教學資源或短片教人製作Deepfake照片或影像。當中的流程包括了三個步驟:一是讓人工智能模型從圖像中提取數據;二是訓練模型,用一些時間(以小時計)去告訴它何時做對,何時做錯,讓它從中學習;三是轉換,以圖片融合技術達成人物轉換的目的。[3] 而現在已發展到有免費的應用程式可以替照片及影片中的人物「換臉」,只要上傳來源照片及預期風格照片,AI就會自動將來源照片的人臉,換到預期風格照片的人物中,生成全新的換臉照,效果亦相當逼真。[4]

而Deepfake影片能夠做到以下幾種效果:

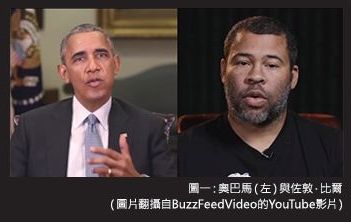

1. 分析A影片人物所說的話,提取數據並套入到B影片人物的口中。如在數年前,美國影星Jordan Peele與一間媒體公司合作製作了一條短片,將Peele所說的話,套入到美國前總統奧巴馬的口中,令他說出髒話。[5]

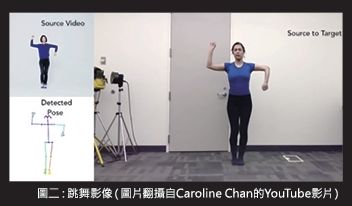

2. 提取人物A的動作(如舞蹈動作)數據,套入人物B(不懂跳舞的人)身上,製作出來的新影像就是人物B在跳舞。[6]

3. 分析一大堆人物A的照片,將分析出來的數據套入另一條影片裡,令本來在影片中的人物B變成人物A,收看者或會相信影片是由人物A親自拍攝的。如網上就曾有人製作了一條短片,將1994年播放的電視劇《射鵰英雄傳》中黃蓉,由朱茵換成內地女演員楊冪。[7]

上述短片的效果都相當逼真,就以「奧巴馬」的短片為例,Peele的話,在套入奧巴馬的影像後,其聲線、語氣、動態都和奧巴馬本人幾乎一樣,只是奧巴馬在公眾場合絕不會說一些粗鄙的言語,但在這段偽造的短片中,「他」就公開說出了這些話,而製作這條短片的目的,正正是要提醒網民留意虛假資訊。

Deepfake淪為犯罪工具

這種技術的應用正在慢慢普及,但卻大多被用來製作惡搞影片或色情影像,結果Deepfake成為了一些立心不良的人,偽造影片的工具。雖然社交平台Reddit,色情網站Pornhub已經禁止所有移花接木的Deepfake色情片段,但在網海內還有無數渠道可以將這類影片發放及傳送。

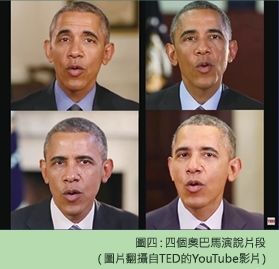

Deepfake技術的影響十分深遠,這門技術經過多年發展,足以欺騙沒有受過訓練的大眾。以往,電腦科學家Supasorn Suwajanakorn就曾於一個公開講座展示四個奧巴馬的演說短片,與會者都無法分辨哪一個才是真正的奧巴馬,但原來四個奧巴馬都是透過演算法等技術偽造出來的。[8] 這代表在政治角力上,野心家可以為了爭取選票或權力,使用這種技術來製造抹黑對手的黑材料。

於本港,警方於2024年2月公佈,接獲全港第一宗利用Deepfake技術進行多人視像會議的詐騙案件,騙徒騙去了一間跨國公司約2億元款項。騙徒向該公司的香港財務人員發放一條短訊,稱自己是總公司的首席財務官,要求進行機密交易,並在交易前進行了線上多人視像會議。騙徒(應不止一人)於會議中使用Deepfake技術偽裝成該名首席財務官及其他與會者,過程中香港職員被指示進行轉賬交易,前後共進行了15次轉賬,將總額約2億元款項轉入五個本地銀行的賬戶中。[9] 案件震驚商界人士,而其後亦有類似的騙案出現,可見Deepfake技術令人防不勝防。

科技正在發展,人類沒可能走回頭路,只能對未來所見的影像、相片保持警惕,不要輕信,尤其是要留意資料來源,愈奇怪、無法追尋消息來源的影片或資訊,就愈要抱懷疑的態度。對於學生,在接觸到AI、Deepfake這些新鮮的技術時,可能會想利用它們來捉弄同學,甚至藉此欺凌其他同學。2024年就有報道指,南韓女性人權振興院公佈,2024年首八個月網上性犯罪受害人中,未成年人佔的比率達36.9%。當地的教職員工會就估計有逾40所學校受到影響。更有涉事的學校呼籲學生清空社交平台上的照片,相信此舉是為免照片成為「來源照」,被用來創作更多新圖像,令學生成為被欺凌的對象。

小心保護個人影像

的確,如不想被人用Deepfake技術將自己轉換成為虛假影片的主角,就要好好保護自己的影像,不要讓陌生人輕易取得;因為愈多不同的影像(如不同的表情或從不同的角度拍攝的影像)成為影像生成的數據,製作出來的虛假影像就會愈神似。以此來看,公眾人物很容易便會成為Deepfake的主角,他們亦要承擔更高的風險。

這門技術的確有其危險的一面,不過,如果將它用於正途,在製作電影、製作回顧歷史事件、緬懷名人、已逝世親人的影片時使用它,不單可以減低拍攝危險場面的風險,也可以提高逼真程度和真實感。如能活化人物的形象,更可以拉近我們與被緬懷者的距離。

(本文原載於第126期〔2019年5月〕《燭光》,其後曾作修訂。)

[1] 孔祥威:〈【科技.未來】Deepfake假得迫真 深度造假模糊真相甚麼才可信?〉,《香港01》,2025年2月12日,網站:https://www.hk01.com/周報/268011/科技-未來-deepfake假得迫真-深度造假模糊真相什麼才可信(最後參閱日期:2025年4月11日)。

[2] Rachel Hale, “Her classmate used AI to make deepfake nude images of her. Experts say it's not uncommon,” USA TODAY and Yahoo! News, last modified March 26, 2025, https://www.yahoo.com/news/her-classmate-used-ai-deepfake-110118413.html; “Deepfake sex crimes widespread among teens in South Korea,” The Straits Times, last modified August 24, 2024, https://www.straitstimes.com/asia/east-asia/deepfake-sex-crimes-widespread-among-teens-in-south-korea.

[3] 阿蒙:〈深度解密換臉應用Deepfake〉,知乎,2018年2月27日,網站:https://zhuanlan.zhihu.com/p/34042498(最後參閱日期:2024年4月11日)。

[4] Emily Wu:〈免費 Deepfake軟體/app/網站推薦,一鍵替換照片及影片人臉!〉,CyberLink,2024年10月25日,網站:https://tw.cyberlink.com/blog/photo-editing-tips/3039/deepfake-tools(最後參閱日期:2025年4月11日)。

[5] Good Morning America, “Jordan Peele uses AI, President Obama in fake news PSA,” YouTube, last modified April 18, 2018, https://www.youtube.com/watch?v=bE1KWpoX9Hk.

[6] Caroline Chan, “Everybody Dance Now,” YouTube, last modified August 23, 2018, https://www.youtube.com/watch?v=PCBTZh41Ris.

[7] 〈AI換臉朱茵變楊冪 網絡爆發爭議〉,星島網,2019年3月1日,網站:https://www.stheadline.com/realtime-china/1913666/AI換臉朱茵變楊冪-網絡爆發爭議(最後參閱日期:2025年9月4日)。

[8] TED, “Fake videos of real people -- and how to spot them | Supasorn Suwajanakorn,” YouTube, last modified July 25, 2018, https://www.youtube.com/watch?v=o2DDU4g0PRo.

[9] 成依華:〈AI深偽騙案 英國企業奧雅納證實受害 香港員工轉帳近2億元〉,《香港01》,2024年6月26日,網站:https://www.hk01.com/即時國際/1020452/ai深偽騙案-英國企業奧雅納證實受害-香港員工轉帳近2億元(最後參閱日期:2025年4月15日)。